Integração Salesforce com AWS AppFlow e S3

- leandro pereira

- 1 de abr. de 2022

- 3 min de leitura

Atualizado: 29 de abr. de 2023

É muito comum que Devs Salesforce precisem integrar dados do CRM com um banco de dados ou data lake por exemplo de uma empresa. Quando o volume desses dados são altos, fazer essa integração via REST pode não ser a forma mais elegante, até porque o próprio Salesforce possui algumas travas que dificultam por exemplo enviar um payload com uma lista de objetos para integração.

O passo a passo a seguir mostra como podemos enviar dados de uma API qualquer para o Salesforce ou do Salesforce para qualquer API utilizando o serviço AppFlow da AWS para a orquestração e S3 para integração.

Envio de dados do Salesforce para S3

Vamos criar um objeto simples para simular a integração.

No Salesforce vá em Setup e procure por Integrations >> Platform Events e crie um novo evento.

Na seção Custom Fields, vamos criar apenas dois campos para exemplificar, ID e Name.

Agora, vamos focar em algumas tarefas no painel AWS. Procure pelo serviço AppFlow e crie um novo Fluxo.

Dê um nome para o Fluxo e clique em próximo.

No segundo passo, você deverá selecionar a origem do evento. Nesse caso, dentre as diversas opções você encontrará “Salesforce”. Após selecionar, você precisará especificar a conexão. Faça login na conta de sua preferencia (Production ou Sandbox) e prossiga. Ainda nesse formulário de origem, selecione o evento criado no Salesforce no primeiro passo deste tutorial.

No formulário de destino, selecione um bucket do S3 onde deseja que os arquivos de integração sejam salvos e prossiga.

Na próxima tela, faça o mapeamento dos campos do Evento que você deseja salvar no arquivo S3.

Clique em próximo no Passo 4 e em Criar Fluxo no passo 5.

Será exibida uma mensagem que o Fluxo foi criado. Por fim, clique em Ativar Fluxo.

Pronto!!! O Fluxo já está com status ativo.

Agora vamos escrever um simples teste no Salesforce para enviar um evento e verificar o funcionamento do nosso fluxo criado acima.

Abra o Developer Console do Salesforce, vá em Debug e selecione Open Execute Anonymous Window.

Vamos publicar um simples evento como o exemplo abaixo:

EventTest__e myEvent = new EventTest__e();

myEvent.ID__c = 1;

myEvent.Name__c = 'My First Event';

EventBus.publish(myEvent);E… PRONTO!

Agora é só verificar o S3 e você irá encontrar uma pasta com o nome do Fluxo e os arquivos do evento na pasta.

Nessa situação você pode conectar qualquer API do seu ambiente externo ao Salesforce e consumir esses dados.

Envio de Dados S3 para Salesforce

E se podemos usar o S3 para consumir os dados do Salesforce por uma API externa, também podemos usá-lo para enviar dados para o CRM. Nesse caso faremos da seguinte forma.

Dentro do mesmo bucket S3 do exemplo anterior, criaremos uma pasta chamada ingest que usaremos para enviar os arquivos com os dados que queremos integrar com o Salesforce.

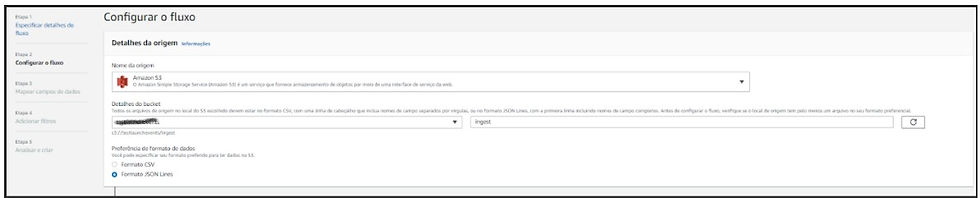

Agora, voltamos ao AppFlow e vamos criar um novo fluxo.

No próximo passo, selecionamos o bucket e a pasta criada e ainda o formato de dados JSON.

Em seguida, informamos o destino desses dados, selecionamos Salesforce, a sandbox e o objeto onde será inserido os dados. Nesse caso, criamos um objeto customizado no Salesforce chamado S3EventIngest.

Nesse primeiro momento, deve ser adicionado a pasta especificada acima “ingest”, um arquivo JSON contendo um mapeamento DE-PARA relacionando os atributos do Json que será consumido pelo fluxo e os campos referentes ao salesforce.

No caso, adicionamos o um arquivo.json com o seguinte código:

{"ID":"ID__c","Name":"Name__c"}

No próximo passo, faça o mapeamento dos atributos JSON que serão enviados no arquivo para o S3 para os campos do objeto Salesforce.

Com o mapeamento feito, seguiremos os próximos passos sem fazer nenhuma modificação até que o fluxo seja concluído e criado.

É possível configurar triggers para que o fluxo seja executado de forma periódica, mas aqui vamos apenas executar manualmente.

Depois de criado, podemos fazer um teste simples. Para isso, vamos EXCLUIR o arquivo da pasta ingest que adicionamos anteriormente e adicionar um arquivo com registros reais de fato.

Nesse caso, vamos adicionar a pasta ingest um arquivo com o seguinte json:

[

{"ID":779,"Name":"My Event Json 1"},

{"ID":780,"Name":"My Event Json 2"},

{"ID":781,"Name":"My Event Json 3"},

{"ID":782,"Name":"My Event Json 4"}

]Após carregar o arquivo no S3, volte ao fluxo e clique no botão “Executar Fluxo”

Espere alguns segundos e você verá uma mensagem de sucesso e também pode consultar o histórico de execução com os últimos processamentos.

Além disso, consulte também no Salesforce e você verá os dados inseridos.

É isso pessoal, espero ter ajudado!!

Comments